近期,科技界傳來一則引人注目的消息,英偉達(dá)研究團(tuán)隊(duì)在人工智能領(lǐng)域取得了重要突破。據(jù)科技媒體marktechpost報(bào)道,英偉達(dá)不僅推出了一種名為ProRL的強(qiáng)化學(xué)習(xí)方法,還成功開發(fā)出了目前全球頂尖的1.5B參數(shù)推理模型——Nemotron-Research-Reasoning-Qwen-1.5B。

推理模型,作為專門設(shè)計(jì)的人工智能系統(tǒng),其核心在于通過復(fù)雜的長鏈推理過程,得出最終的答案。這一技術(shù)在近年來備受關(guān)注,而強(qiáng)化學(xué)習(xí)在這一過程中的作用更是不可忽視。此前,DeepSeek和Kimi等團(tuán)隊(duì)已采用可驗(yàn)證獎(jiǎng)勵(lì)的強(qiáng)化學(xué)習(xí)方法(RLVR),推動(dòng)了GRPO、Mirror Descent和RLOO等算法的發(fā)展。

然而,盡管強(qiáng)化學(xué)習(xí)在理論上被認(rèn)為能夠提升大型語言模型(LLM)的推理能力,但實(shí)際應(yīng)用中卻面臨諸多挑戰(zhàn)。現(xiàn)有研究表明,RLVR在pass@k指標(biāo)上并未顯著優(yōu)于基礎(chǔ)模型,這顯示出推理能力的擴(kuò)展存在局限性。當(dāng)前的研究大多聚焦于數(shù)學(xué)等特定領(lǐng)域,導(dǎo)致模型過度訓(xùn)練,限制了其探索新領(lǐng)域的潛力。同時(shí),強(qiáng)化學(xué)習(xí)的訓(xùn)練步數(shù)通常較短,往往僅數(shù)百步,這使得模型難以充分發(fā)展新的能力。

為了克服這些難題,英偉達(dá)研究團(tuán)隊(duì)推出了ProRL方法。他們不僅將強(qiáng)化學(xué)習(xí)的訓(xùn)練時(shí)間延長至超過2000步,還大大擴(kuò)展了訓(xùn)練數(shù)據(jù)的范圍,涵蓋了數(shù)學(xué)、編程、STEM、邏輯謎題和指令遵循等多個(gè)領(lǐng)域,共計(jì)13.6萬個(gè)樣本。這一舉措旨在提升模型的泛化能力,使其能夠在不同領(lǐng)域都表現(xiàn)出色。

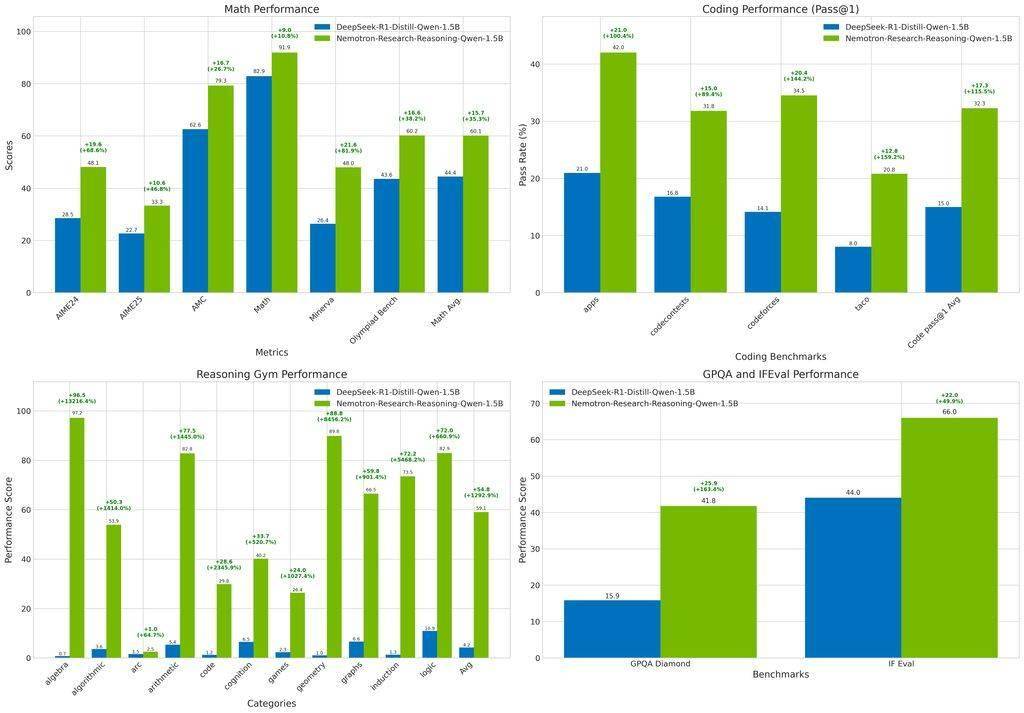

在ProRL方法的基礎(chǔ)上,英偉達(dá)團(tuán)隊(duì)采用了verl框架和改進(jìn)的GRPO方法,成功開發(fā)出了Nemotron-Research-Reasoning-Qwen-1.5B模型。這一模型在多項(xiàng)基準(zhǔn)測試中均表現(xiàn)出色,超越了基礎(chǔ)模型DeepSeek-R1-1.5B,甚至在某些方面優(yōu)于更大的DeepSeek-R1-7B模型。

測試結(jié)果顯示,Nemotron-Research-Reasoning-Qwen-1.5B模型在數(shù)學(xué)領(lǐng)域?qū)崿F(xiàn)了平均15.7%的提升,編程任務(wù)的pass@1準(zhǔn)確率提高了14.4%,在STEM推理和指令遵循方面分別提升了25.9%和22.0%,邏輯謎題的獎(jiǎng)勵(lì)值更是提升了驚人的54.8%。這一系列數(shù)據(jù)充分展示了該模型在不同領(lǐng)域中的強(qiáng)大推理能力和泛化性能。

英偉達(dá)的這一突破無疑為人工智能領(lǐng)域帶來了新的希望和可能。隨著技術(shù)的不斷進(jìn)步和應(yīng)用的不斷拓展,我們有理由相信,未來將有更多像Nemotron-Research-Reasoning-Qwen-1.5B這樣的優(yōu)秀模型涌現(xiàn)出來,為人類社會(huì)帶來更多的便利和價(jià)值。