近期,科技界傳來了一項引人注目的創新消息,谷歌DeepMind團隊與布朗大學攜手,為視頻生成領域帶來了一項名為“力提示”的突破性技術。這項技術能夠在不依賴3D模型或物理引擎的前提下,生成極為逼真的動態效果。

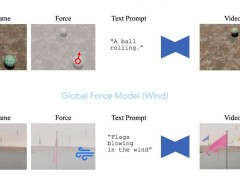

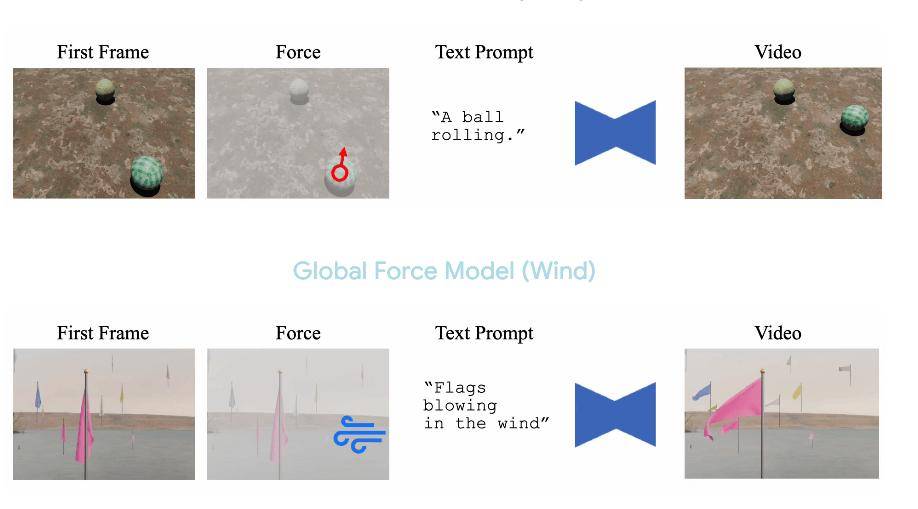

通過“力提示”技術,用戶只需簡單指定力的方向和強度,即可操控AI生成的視頻內容。這項技術支持全局力和局部力兩種類型,全局力如風吹過整個畫面,局部力則像是特定點的敲擊。這些力以矢量場的形式輸入系統,隨后被轉化為自然且流暢的運動。

研究團隊基于CogVideoX-5B-I2V視頻模型,融入了ControlNet模塊來處理物理控制數據。信號通過Transformer架構生成視頻,每段視頻包含49幀,整個訓練過程僅使用了4臺Nvidia A100 GPU,并在一天內完成。

尤為訓練數據完全由合成數據構成。全局力數據涵蓋了1.5萬段不同風力下旗幟飄動的視頻,而局部力數據則包括了1.2萬段滾動球體和1.1萬段花朵受沖擊反應的視頻。

在視頻生成過程中,當文本描述中加入“風”或“氣泡”等物理術語時,模型能夠自動建立起正確的力與運動關系。訓練樣本結合了文本提示、起始圖像和物理力,全局力以完整矢量場形式呈現,局部力則以方向、位置和強度的動態信號形式存在。為了增加多樣性,背景、光線和視角都被隨機化處理。

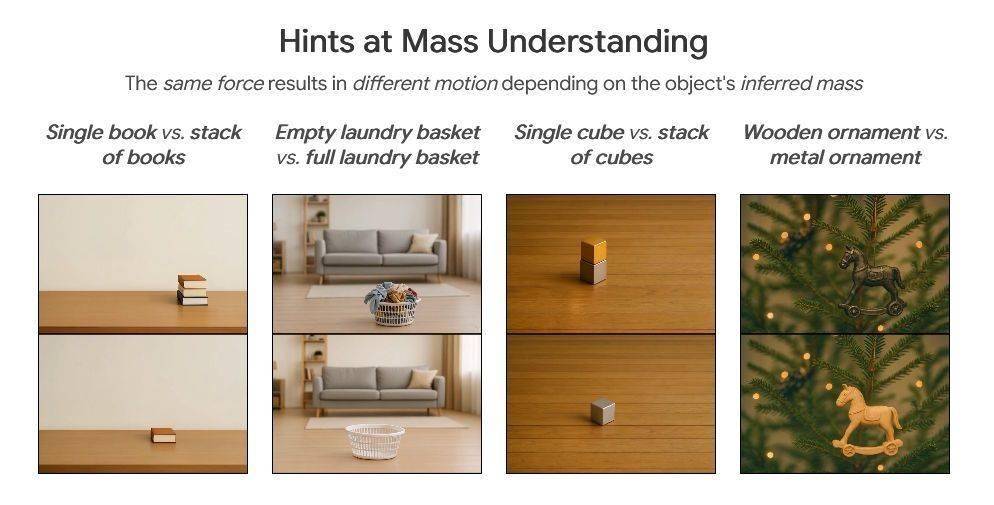

盡管訓練數據相對有限,但模型展現出了令人驚嘆的泛化能力。它能夠適應新物體、材質和場景,甚至掌握了簡單的物理規則,例如在同一力度下,輕物移動的距離會比重物更遠。

在用戶測試中,“力提示”技術在運動匹配度和真實感方面表現優異,超越了純文本或運動路徑控制的基準模型,甚至在某些方面超過了依賴真實物理模擬的PhysDreamer,僅在圖像質量上略遜一籌。然而,在復雜場景中仍存在一些缺陷,例如煙霧有時會無視風力,人體手臂的移動偶爾顯得像布料一樣不自然。

DeepMind的首席執行官Demis Hassabis近期表示,新一代AI視頻模型(如Veo 3)正在逐步理解物理規則,不再局限于文本或圖像處理,而是開始表征世界的物理結構。他認為,這是通向更通用AI的關鍵一步,未來AI或許將不再僅僅依賴數據,而是能夠在模擬環境中通過經驗進行學習。