近期,人工智能領域的一項新研究引發了廣泛關注。Giskard團隊在其官方博客上發布了一項重要發現,揭示了AI模型在簡潔回答要求下,事實性表現會受到顯著影響。這一發現對于AI技術的實際應用具有重要意義。

研究表明,當AI模型被要求用更短的篇幅回答問題,特別是面對模糊主題時,其產生錯誤信息的傾向會大幅增加。Giskard團隊指出,簡單的系統指令調整就能顯著改變模型產生“幻覺”的概率。這一現象在許多實際應用中尤為關鍵,因為為了提高響應速度和降低成本,系統往往傾向于選擇簡潔的輸出結果。

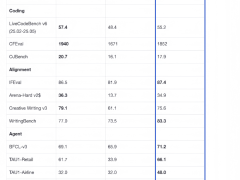

所謂“幻覺”,一直是人工智能領域難以攻克的問題。即便是最先進的AI模型,有時也會編造虛假信息。值得注意的是,一些新型推理模型,如OpenAI的o3,其“幻覺”現象甚至更為嚴重,這極大地降低了輸出結果的可信度。在Giskard的研究中,包括GPT-4o(ChatGPT的默認模型)、Mistral Large和Anthropic的Claude 3.7 Sonnet在內的多個領先模型,在面臨簡潔回答的要求時,其事實準確性均有所下降。

Giskard團隊推測,當模型被要求不詳細回答時,它們沒有足夠的“余地”去指出錯誤的提示詞。換句話說,強有力的反駁通常需要更長的解釋。因此,當模型被迫保持簡潔時,它們往往會選擇簡潔而非準確性。這一發現對開發者來說尤為重要,因為看似無害的系統提示詞,如“簡潔明了”,可能會削弱模型反駁錯誤信息的能力。

Giskard的研究還揭示了一些其他有趣的現象。例如,當用戶自信地提出有爭議的主張時,模型更不愿意進行反駁。用戶表示更喜歡的模型并不一定是最真實的。這一發現進一步強調了用戶體驗優化與事實準確性之間的矛盾,尤其是在用戶期望包含錯誤前提時。

Giskard團隊的研究人員指出,盡管優化用戶體驗是提升系統吸引力的重要因素,但有時候這種優化可能會以犧牲事實準確性為代價。這提醒我們在實際應用AI技術時,需要更加謹慎地權衡用戶體驗與事實準確性之間的關系,以確保AI技術的可靠性和可信度。