近日,通義千問在其技術(shù)更新中揭曉了兩款全新的小型語言模型——Qwen3-4B-Instruct-2507與Qwen3-4B-Thinking-2507,這兩款模型以其精簡(jiǎn)的尺寸和卓越的性能引起了業(yè)界的廣泛關(guān)注。

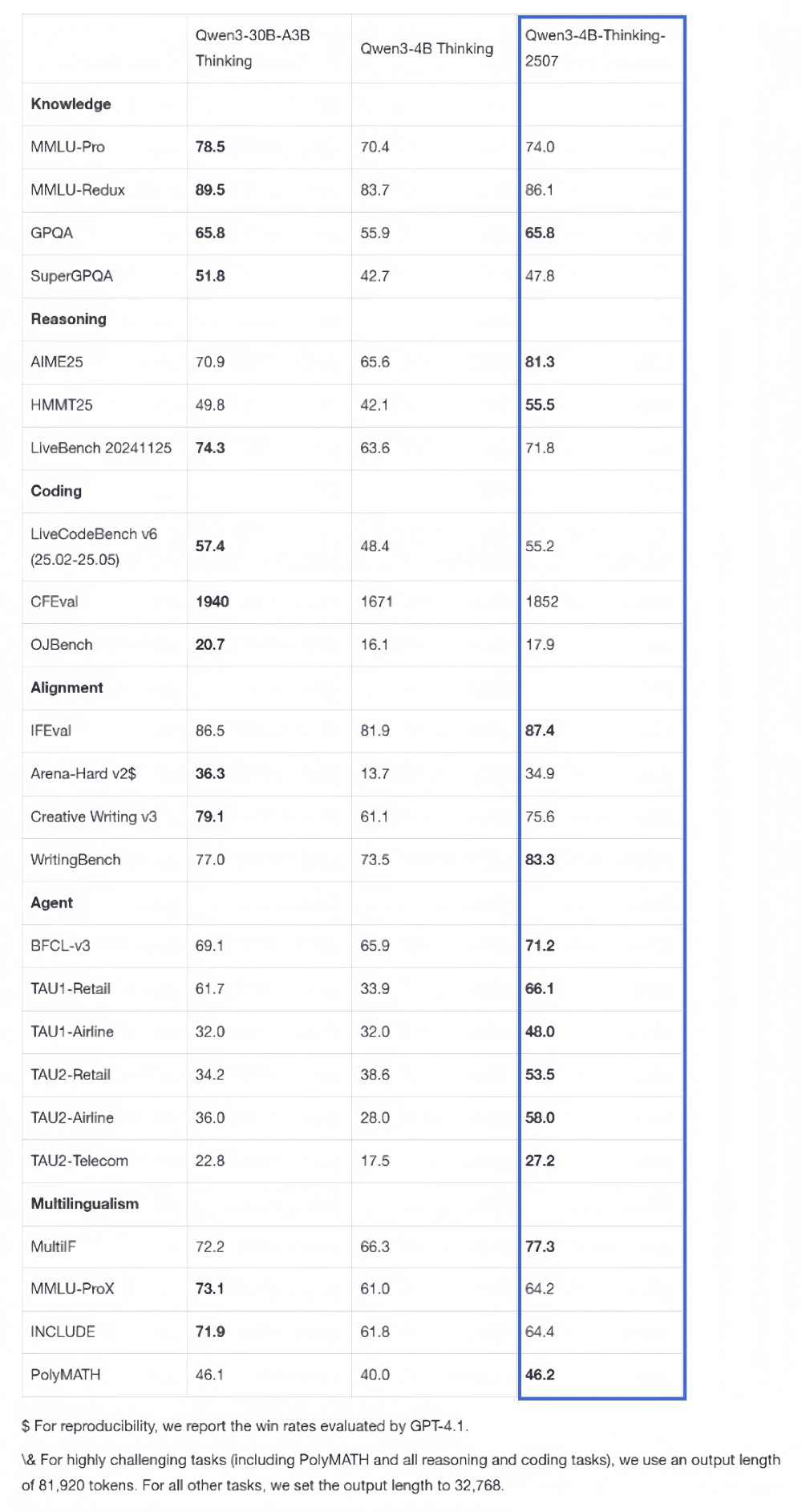

據(jù)悉,Qwen3-4B系列的兩款新模型在設(shè)計(jì)上充分考慮了端側(cè)硬件的部署需求,旨在為用戶提供更加高效、靈活的AI解決方案。其中,Qwen3-4B-Thinking-2507在推理能力上展現(xiàn)出了與中尺寸模型相當(dāng)?shù)膶?shí)力,而Qwen3-4B-Instruct-2507則在知識(shí)、推理、編程、對(duì)齊及agent能力等多個(gè)方面全面超越了閉源的GPT-4.1-nano模型。

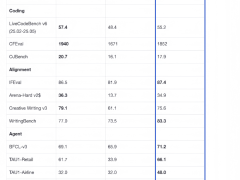

這兩款新模型的上下文理解能力得到了顯著提升,擴(kuò)展至256K,使其能夠處理更長(zhǎng)的文本,并支持復(fù)雜的文檔分析、長(zhǎng)篇內(nèi)容生成及跨段落推理等應(yīng)用場(chǎng)景。在性能測(cè)試中,Qwen3-4B-Thinking-2507在復(fù)雜問題推理、數(shù)學(xué)能力、代碼能力及多輪函數(shù)調(diào)用等方面均表現(xiàn)出色,而Qwen3-4B-Instruct-2507則在Arena-Hard v2基準(zhǔn)測(cè)試中取得了43.4分的高分。

值得注意的是,Qwen3-4B-Instruct-2507在非推理領(lǐng)域同樣展現(xiàn)出了強(qiáng)大的實(shí)力,全面超越了GPT-4.1-nano模型,并且其性能已接近中等規(guī)模的Qwen3-30B-A3B(non-thinking)模型。該模型覆蓋了更廣泛的語言知識(shí),與人類偏好在主觀和開放性任務(wù)中的對(duì)齊性得到增強(qiáng),能夠提供更貼近用戶需求的答復(fù)。

在推理領(lǐng)域,Qwen3-4B-Thinking-2507更是表現(xiàn)出色,其推理能力足以媲美中等模型Qwen3-30B-Thinking。特別是在數(shù)學(xué)能力的測(cè)試中,該模型以4B的參數(shù)量取得了81.3分的高分。其通用能力也得到了顯著提升,Agent分?jǐn)?shù)甚至超越了更大尺寸的Qwen3-30B-Thinking模型。

通義千問此次推出的Qwen3-4B系列新模型,不僅實(shí)現(xiàn)了性能上的優(yōu)化,更在通用能力上展現(xiàn)出了超越同級(jí)別模型甚至逼近中大規(guī)模模型的實(shí)力。同時(shí),這兩款小型語言模型對(duì)端側(cè)硬件的友好度也更高,為用戶提供了更加靈活、高效的AI解決方案。這一創(chuàng)新舉措無疑將加速AI技術(shù)在端側(cè)設(shè)備的滲透,推動(dòng)更多輕量化、場(chǎng)景化的智能應(yīng)用落地。