近期,上海交通大學與AI Infra領域的創新企業魔形智能攜手,在國際高性能計算機架構研討會HPCA 2025上發表了一篇題為《VQ-LLM: 高性能向量量化增強的大語言模型推理代碼生成》的論文。該研究提出了一種名為VQ-LLM的框架,通過引入分層代碼本緩存和代碼本中心計算引擎兩大創新技術,實現了超過50%的推理延遲降低,性能超越了傳統逐元素量化方法。

VQ-LLM框架的成功,為向量量化技術在大語言模型中的實際應用提供了切實可行的方案。在保持模型高精度的同時,顯著提升了推理效率。這一突破不僅解決了大模型計算量大、存儲空間需求高的難題,還為向量量化技術的未來發展開辟了新的道路。

上海交通大學計算機科學與工程系教授冷靜文是此次論文工作的主要負責人。冷靜文教授自2010年從上海交通大學獲得學士學位后,于2016年在德州大學奧斯汀分校獲得電子與計算機工程系博士學位,專攻GPU處理器體系結構優化。目前,冷靜文教授及其團隊的研究興趣集中在芯片架構和硬件互聯方面,特別是數據流芯片設計和超節點高速互聯域的硬件設計。

在談到此次與魔形智能的合作時,冷靜文教授表示,大模型壓縮是當前熱門的研究方向,但傳統的單元素量化方法存在局限性。向量量化技術通過挖掘元素間的相關性,能夠實現更高效的壓縮,同時保持模型的精度。此次合作將向量量化技術應用于大語言模型,取得了顯著的成果。

冷靜文教授還分享了團隊在數據流芯片研究方面的進展。他認為,當前GPU的紅利已經接近尾聲,未來芯片的架構和編程方法需要新的思考。數據流芯片作為一種創新的架構,有望解決當前芯片設計中的一些瓶頸問題。冷靜文教授及其團隊正在致力于構建數據流芯片的抽象模型和編程語言,以降低學習成本并推動其廣泛應用。

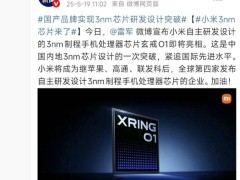

在談到國產芯片的發展時,冷靜文教授表示,國產芯片廠商需要擺脫對英偉達等國外廠商的依賴,進行原創性思考。他認為,國產芯片廠商應該注重生態的構建,同時解決高帶寬內存設計等問題。冷靜文教授還提到了英偉達H20芯片出口受限對國內的影響,并建議國內芯片廠商考慮采用CXL互聯方式或3D堆疊芯片等技術來緩解HBM的需求。

冷靜文教授還分享了團隊在大型模型優化方面的經驗。他認為,系統的優化方法可以指導大模型的設計,特別是需要找到系統當前的瓶頸并結合模型的特點進行聯合設計。冷靜文教授還提到了NSA等前沿工作,認為這些工作為模型設計帶來了新的思考,即將效率優先的原則帶入到模型結構中去。

在談到向量量化技術的未來應用時,冷靜文教授表示,目前向量量化主要用于推理階段,但未來可以考慮將其與訓練過程相結合,以實現更高效的模型壓縮和加速。冷靜文教授還提到了DeepSeek等前沿工作對大模型量化的挑戰和機遇,認為這些工作為向量量化技術提供了新的思路和方法。

冷靜文教授及其團隊的研究成果不僅在學術界引起了廣泛關注,也在行業內產生了深遠影響。目前,論文中提出的VQ-LLM框架已經正在被相關產品所采用,為推動大語言模型的廣泛應用和性能提升做出了重要貢獻。

冷靜文教授還強調了芯片、系統和模型廠商之間的協同合作對于推動大模型進一步發展的重要性。他認為,在新的模型架構設計、模型小型化和輕量化等方面,芯片、系統和模型廠商可以發揮各自所長,共同推動大模型的廣泛應用和性能提升。