近期,蘋果公司與杜克大學的一項合作研究引起了科技界的廣泛關注。這項研究提出了一種名為交錯推理的全新強化學習方法,旨在增強大語言模型的推理能力。

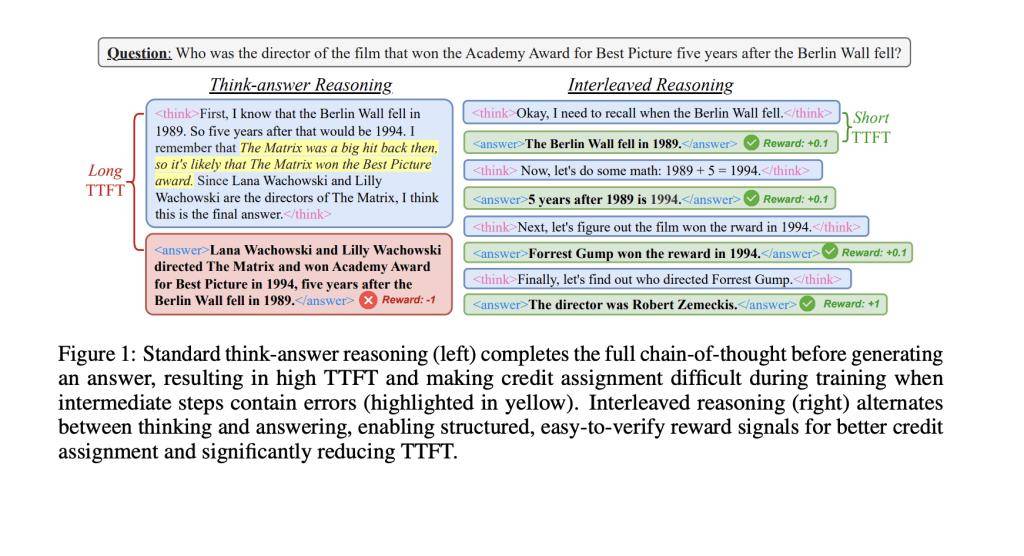

在以往,大型語言模型在處理復雜的多步驟問題時,通常采用一種線性的推理方式,即先完成整個推理過程,再給出答案。然而,這種方式存在明顯缺陷:一方面,它導致了較長的響應時間,無法滿足即時交互的需求;另一方面,一旦推理過程中的某個環節出錯,最終答案的準確性也會大打折扣。

與人類的對話習慣不同,語言模型往往不會在推理過程中分享任何中間想法,而是等待全部推理完成后再一次性輸出結果。這種“閉門造車”的方式,無疑降低了模型的效率。

為了克服這一難題,蘋果與杜克大學的研究人員共同研發了交錯推理技術。這一技術允許模型在推理過程中交替進行內部計算和輸出中間答案,從而極大地提升了速度和實用性。

交錯推理技術基于強化學習框架,采用了一種特殊的訓練模板,其中包含了特定的標簽,以確保模型在關鍵推理節點上能夠輸出中間結果。研究團隊還設計了一套基于規則的獎勵機制,包括格式正確性、最終答案準確率和條件性中間準確率,以引導模型注重整體推理的準確性。

在實際測試中,交錯推理技術在Qwen2.5模型(包括1.5B和7B參數版本)上取得了顯著成效。與傳統方法相比,響應速度提升了超過80%,準確率也提高了高達19.3%。更令人矚目的是,該方法僅在問答和邏輯數據集上進行了訓練,卻能夠在MATH、GPQA、MMLU等更具挑戰性的基準測試中展現出強大的泛化能力。

研究團隊還嘗試了多種獎勵策略,如全或無獎勵、部分積分獎勵和時間折扣獎勵等。實驗結果表明,條件性和時間折扣獎勵策略的效果最佳,顯著優于傳統獎勵方法。