在人工智能大模型浪潮的推動下,英偉達的數(shù)據(jù)中心GPU出貨量在2023年實現(xiàn)了顯著增長,總計達到了約376萬臺,相較于前一年的264萬臺,增幅超過百萬臺。這一增長使英偉達成為歷史上硬件公司中規(guī)模增長最快的之一。據(jù)行業(yè)預測,到2025年,英偉達的GPU銷量有望達到650萬至700萬塊。

盡管英偉達在GPU市場上的壟斷地位依舊穩(wěn)固,但圍繞其長期持久性(超過6年)的討論卻從未停歇。面對這一形勢,谷歌、微軟、亞馬遜和meta等海外科技巨頭正積極整合AI需求,力圖成為NPU的主要消費者,并紛紛自研具備競爭力且高度可靠的芯片。

與此同時,計算需求的急劇增加已經(jīng)觸及了資本支出、電力供應和基礎設施建設的極限。這一現(xiàn)狀正促使行業(yè)轉(zhuǎn)向分布式、垂直集成和協(xié)同優(yōu)化的系統(tǒng),包括芯片、機架、網(wǎng)絡、冷卻、基礎設施軟件及電源等方面。然而,英偉達在這一轉(zhuǎn)型過程中顯得準備不足。

據(jù)英偉達透露,在2025財年第四季度,公司交付了價值110億美元的Blackwell芯片,這些芯片主要銷售給云巨頭,占據(jù)了英偉達數(shù)據(jù)中心業(yè)務收入的相當一部分。然而,業(yè)內(nèi)分析認為,云巨頭在英偉達的市場份額可能會縮減,同時,小型或短期GPU租賃廠商的利用率和投資回報率也普遍較低。

隨著前沿模型的成本降低、性能和泛化能力提升,尤其是借助有效的RAG和廣泛可用的微調(diào)機制,許多使用特定數(shù)據(jù)訓練專有模型的公司面臨價值點不明確的問題,這些長尾買家的需求也變得不穩(wěn)定。與此同時,一些小型獨立云廠商的未來前景也不明朗,盡管英偉達曾給予他們資金和GPU支持,但這些廠商在產(chǎn)品多樣性、基礎設施和人才方面仍然匱乏。

相比之下,云巨頭的需求卻迅速增長。外部開發(fā)者面臨長期資源短缺,交付周期長達數(shù)月,而內(nèi)部需求也加劇了這一趨勢。云巨頭憑借其規(guī)模和基礎設施經(jīng)驗,在攤銷折舊和停機成本方面具有優(yōu)勢,同時提供高靈活性、安全性和可靠性,從而獲得了高AI服務利潤率和客戶信任度。

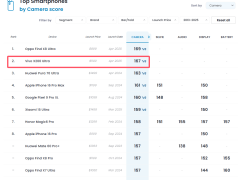

谷歌就是一個典型的例子。自2013年以來,谷歌一直在內(nèi)部開發(fā)TPU。盡管開發(fā)周期長達數(shù)年,但在預算、人才和架構(gòu)有限的情況下,TPU v1從啟動到部署僅用了15個月。并且,歷屆TPU在性能和能耗上相較于GPU都展現(xiàn)出優(yōu)勢。如今,TPU已經(jīng)發(fā)展到第六代Trillium,能效和HBM容量提高了一倍,峰值性能提高了三倍以上。而谷歌也在迭代其軟件堆棧,由TensorFlow過渡到JAX,用于處理編譯和低級部署優(yōu)化。TPU和JAX的組合幾乎完全取代了谷歌內(nèi)部用于AI工作負載的英偉達GPU。

本月初,谷歌發(fā)布了第七代TPU“Ironwood”,作為谷歌首款面向AI推理時代的TPU,單芯片峰值算力可達4614 TFLOPs。Ironwood可擴展至9216片芯片集群,性能是第六代TPU Trillium的兩倍,并且能效較之于第一款Cloud TPU高出近30倍。HBM帶寬也有所提升,單顆Ironwood芯片的內(nèi)存帶寬達7.2Tbps,是Trillium的4.5倍。

除了谷歌,亞馬遜也在加速芯片開發(fā)。自2015年收購Annapurna Labs后,亞馬遜推出了第二代Inferentia和新的Trainium芯片。預計到2026年,相關(guān)支出將達到25億美元。微軟則推出了自研AI芯片Maia 100芯片和相關(guān)的Cobalt 100 CPU,并推出了兼容Pytorch的編譯器Maia SDK,依靠OpenAI的Triton框架來取代CUDA。

meta同樣在布局ASIC。早期,meta芯片主要為Instagram和Reels提供DLRM。隨著第二代MTIA芯片發(fā)布和支持定制軟件堆棧,meta已開始在Facebook和Instagram的新聞推送推薦系統(tǒng)中使用推理芯片。meta還在合成數(shù)據(jù)生成方面擴大芯片使用,并據(jù)外媒報道,已經(jīng)在小規(guī)模部署測試其首款用于AI訓練的自研芯片。

當前,AI的工作負載偏向于訓練。即使在微軟,訓練也約占算力需求的六成。然而,隨著重心由訓練轉(zhuǎn)向推理,英偉達面臨的壓力也在增大。業(yè)內(nèi)分析認為,在許多情況下,尤其是對于中型模型,上一代A100的性價比都高于H100。而AMD也正在成為更具競爭力的替代品。甚至從長遠來看,尤其是對于小模型而言,基于CPU的推理或為最佳選擇。

分布式系統(tǒng)帶來的挑戰(zhàn)同樣不容忽視。盡管英偉達B100的單芯片性能相當于3個Trillium TPU,但有觀點認為,單芯片性能并不重要。云巨頭能夠垂直整合并利用其規(guī)模和專業(yè)打造總體上更經(jīng)濟、性能更高的分布式系統(tǒng)。這對于英偉達而言,將是一個難以競爭或適應的結(jié)構(gòu)性趨勢。

微軟的數(shù)據(jù)中心設計就是一個例證。他們規(guī)劃了自己的電信光纖網(wǎng)絡,并推出新的ColorZ可插拔光收發(fā)器+DSP,以支持長距離數(shù)據(jù)傳輸,通過連接數(shù)據(jù)中心有效提高峰值集群性能。而谷歌則放棄了大型芯片,轉(zhuǎn)而采用體積更小、成本更低、且具有深度互連的ASIC集群。這些努力都顯著提高了系統(tǒng)的整體性能和效率。

基礎設施正在變得愈發(fā)分布式。以meta為例,Llama 3的訓練并非集中于單一數(shù)據(jù)中心。由于需要在包括AWS、Oracle等云上進行訓練,meta正在通過與HammerSpace合作將多云多數(shù)據(jù)中心的數(shù)據(jù)完全統(tǒng)一起來。微軟也正在為OpenAI連接遍布全國的集群。海外巨頭都在積極探索實現(xiàn)真正的異步分布式訓練。

分布式基礎設施是繼續(xù)擴展和計算新OOM的唯一途徑。目前,算力仍舊是前沿模型發(fā)展的最大制約因素。而多數(shù)據(jù)中心訓練允許使用規(guī)模較小、互聯(lián)互通的數(shù)據(jù)中心,這不僅降低了成本,而且提高了吞吐量。同時,也加速了基礎設施的建設。

然而,盡管分布式系統(tǒng)為非傳統(tǒng)但資金雄厚的參與者創(chuàng)造了一些機會,但基礎設施專業(yè)知識至關(guān)重要。巨頭必須不斷擴展以訓練出更優(yōu)秀的模型。長期來看,關(guān)鍵區(qū)別在于訓練將在x00MW-xGW數(shù)據(jù)中心的“小型”聯(lián)網(wǎng)園區(qū)中進行,而不是在xxGW級的單體數(shù)據(jù)中心中進行。

基于前述趨勢,業(yè)內(nèi)分析認為,英偉達將很難在性能或成本上競爭。其既無法與云深度集成,也無法定制硬件。除非發(fā)展出規(guī)模較小的客戶,否則英偉達本身并不適合服務于跨集群或百億億次級的情況。英偉達面臨著前所未有的長期挑戰(zhàn)。