近日,字節跳動旗下的豆包大模型團隊揭曉了其最新思考模型Seed-Thinking-v1.5的技術細節,并宣布該模型將于4月17日通過火山引擎開放接口供用戶體驗。這一消息標志著字節跳動在自然語言處理領域邁出了重要一步。

Seed-Thinking-v1.5模型在多個領域展現出了卓越的性能。在數學推理方面,它在AIME 2024競賽中取得了86.7的高分,與OpenAI的o3-mini-high模型不相上下。在編程競賽中,該模型在Codeforces平臺上的通過率達到了55.0%,接近Gemini 2.5 Pro的水平。在科學推理任務上,Seed-Thinking-v1.5也取得了77.3%的優異成績,同樣接近業界領先模型。而在通用任務中,人類評估顯示其表現超過了DeepSeek R1達8%,能夠覆蓋多種場景需求。

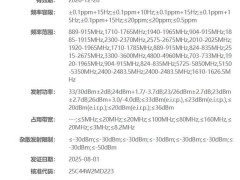

Seed-Thinking-v1.5模型采用了MoE架構,總參數達到200B,但激活參數僅為20B,這使其在保持高性能的同時,具備顯著的推理成本優勢。與DeepSeek R1相比,該模型的單位推理成本降低了50%,實現了性能與效率的完美平衡。

為了提升模型的表現力,豆包大模型團隊在數據處理策略上進行了優化。針對可驗證數據,如數學和代碼題目,團隊通過百萬級數據的三重清洗流程,保留了10萬道高難度題目,并設計了答案整數化改造和離線沙箱驗證等機制,確保模型能夠輸出真實的推理過程。而對于非可驗證數據,如創意寫作,團隊則基于豆包1.5 Pro訓練集,剔除低價值樣本,并采用兩兩對比獎勵法,優化生成質量。

團隊還構建了全新的評測基準,包括超難數學數據集BeyondAIME,該數據集包含100道無答案題干的題目,旨在解決現有測試區分度不足的問題。這一舉措不僅提升了模型的評測準確性,也為后續的優化提供了有力支持。

在獎勵模型方面,團隊提出了雙軌獎勵機制,以兼顧“對錯分明”與“見仁見智”的任務。對于可驗證任務,團隊開發了兩代驗證器,從字符匹配升級為推理步驟逐行對比,確保了模型輸出的準確性。而對于非可驗證任務,團隊則引入pairwise對比訓練,通過大量“AB測試”捕捉人類對創意、情感等的隱性偏好,從而避免了“眾口難調”的問題。這一雙軌獎勵機制不僅提升了模型的訓練效率,也使其在不同場景下都能表現出色。

在訓練方法上,Seed-Thinking-v1.5采用了“監督精調+強化學習”的雙階段優化策略。在監督精調階段,團隊基于40萬高質量實例構建了長思考鏈數據集,并結合人工與模型協同篩選,確保模型能夠“像人類一樣思考”。而在強化學習階段,團隊通過三重數據引擎、算法創新以及在線數據適配技術,解決了訓練不穩定、長鏈推理斷層等問題,使模型能夠在動態調整數據分布的過程中保持最佳訓練狀態。

最后,為了應對20B MoE(總參數200B)的復雜訓練需求,團隊對底層架構進行了優化。HybridFlow編程模型支持算法快速探索與分布式并行運行,流式推理系統(SRS)則通過“流式推理”技術解耦模型演進與異步推理,將訓練速度提升了3倍。三層并行架構結合張量/專家/序列并行,動態均衡負載,基于KARP算法優化GPU算力利用率,為模型的高效訓練提供了有力保障。