小米公司近期宣布了一項重大技術進展,正式向公眾開源了其聲音理解大模型MiDashengLM-7B。這一舉措標志著小米在AI技術研發領域邁出了重要一步,尤其是在聲音理解方面。

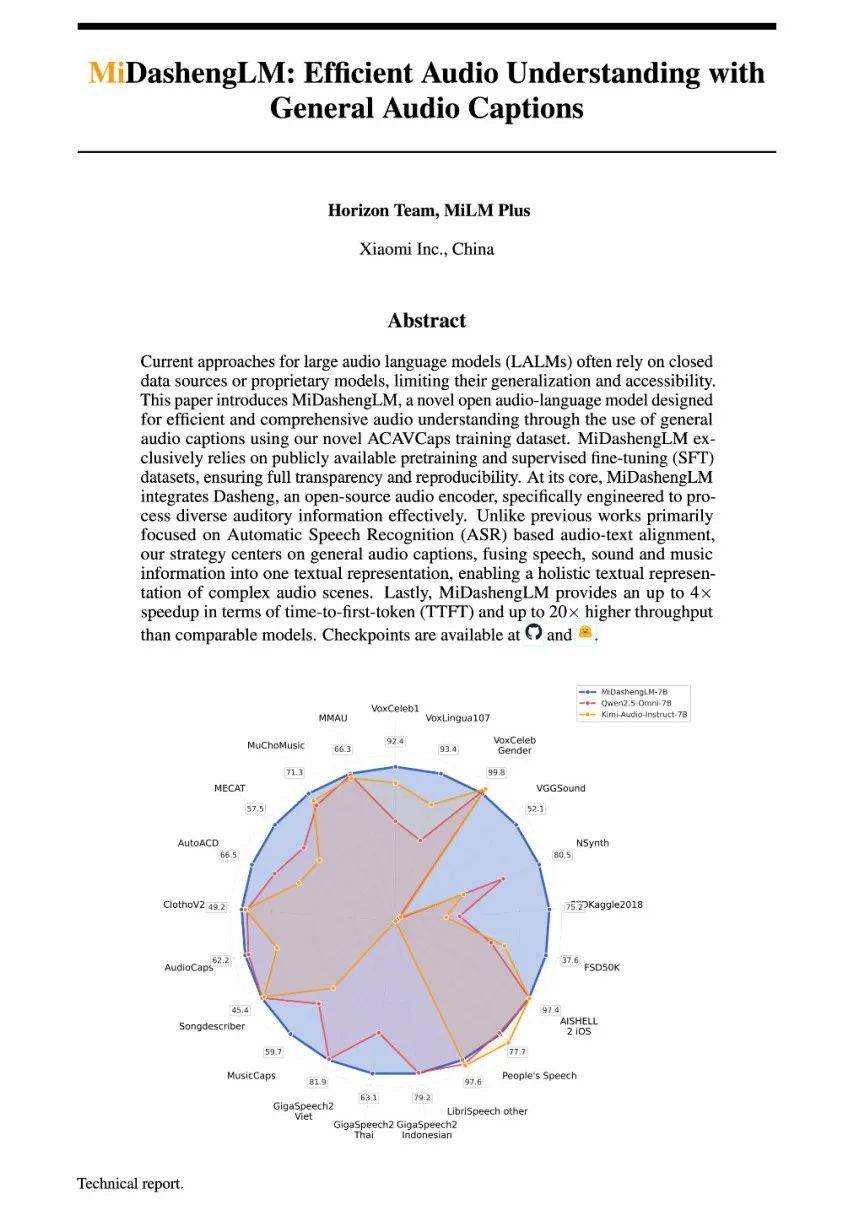

據悉,MiDashengLM-7B在多個公開評測集上刷新了多模態大模型的最佳成績,其單樣本推理的首Token延遲僅為業界先進模型的四分之一,同時在同等顯存下的數據吞吐效率更是達到了業界先進模型的20倍以上。這一卓越性能的實現,得益于小米在音頻編碼器和自回歸解碼器方面的創新設計。

MiDashengLM-7B基于Xiaomi Dasheng音頻編碼器和Qwen2.5-Omni-7B Thinker自回歸解碼器,通過通用音頻描述訓練策略,實現了對語音、環境聲音和音樂的統一理解。這一跨領域的理解能力,使得MiDashengLM-7B不僅能夠準確識別用戶周圍的語音信息,還能深入理解環境聲音和音樂背后的含義,從而提高了用戶場景理解的泛化性。

小米表示,音頻理解是構建全場景智能生態的關鍵領域。MiDashengLM-7B的推出,將進一步推動小米在智能家居、汽車座艙等領域的智能化進程。目前,該系列模型已經在小米的多個產品中得到了應用,為用戶帶來了更加智能、便捷的交互體驗。

值得注意的是,MiDashengLM-7B的訓練數據全部來自公開數據集,涵蓋了語音識別、環境聲音、音樂理解、語音副語言和問答任務等多個領域。小米在數據使用和處理方面的高度透明性,也為業界提供了可復現的參考案例。

在性能表現方面,MiDashengLM-7B在音頻描述、聲音理解、音頻問答等任務中均展現出了明顯的優勢。與同類7B模型相比,MiDashengLM-7B在音頻描述任務中的FENSE指標更高,聲音理解任務中的性能也更勝一籌。在語音識別任務中,MiDashengLM-7B在GigaSpeech 2數據集上的表現尤為突出。

除了卓越的性能表現外,MiDashengLM-7B在推理效率方面也取得了顯著提升。對于單個樣本推理的情形,MiDashengLM-7B的首個token預測時間僅為Qwen2.5-Omni-7B的四分之一。在批次處理時,MiDashengLM-7B能夠在80GB GPU上處理更大的batch size,從而提高了數據吞吐效率。

這一系列優勢的背后,是小米在音頻編碼器設計方面的優化和創新。通過降低音頻編碼器的輸出幀率,小米成功降低了計算負載,實現了推理效率的提升。這一創新設計不僅提高了MiDashengLM-7B的性能表現,也為業界提供了有益的參考和借鑒。

MiDashengLM-7B還采用了通用音頻描述對齊范式進行訓練。這一范式避免了傳統ASR轉錄數據對齊方法的局限性,能夠迫使模型學習音頻場景的深層語義關聯。同時,小米還利用多專家分析管道生成訓練數據,對原始音頻進行細粒度標注,從而提高了模型的訓練效果。

小米表示,未來將繼續對Xiaomi Dasheng系列模型進行升級和優化,尋求在終端設備上實現離線部署。這將進一步推動小米在AI技術研發領域的領先地位,為用戶提供更加智能、便捷的交互體驗。