近期,國內AI大模型領域似乎陷入了一片沉寂,各大項目紛紛選擇低調行事。曾備受矚目的DeepSeek-R2,除了偶爾流傳的半真半假的小道消息外,幾乎再無任何動靜。

回望去年,AI六小虎之間的激烈競爭還歷歷在目,而今年的它們卻仿佛集體進入了冬眠狀態,鮮有新動作。

盡管期間也有新品發布,但總體而言,這些產品都未能激起太大的波瀾,缺乏讓人眼前一亮的創新和吸引力。

然而,就在昨日凌晨,這潭平靜的水被一只突然蘇醒的小虎攪動——MiniMax宣布正式開源其首個推理模型MiniMax-M1。

從跑分圖來看,MiniMax-M1在其他方面的表現算是中規中矩,但在MRCR(上下文長度測試)這一項上,卻展現出了驚人的實力,與眾多開源模型拉開了顯著的差距,僅次于Gemini2.5Pro。

更令人驚訝的是,據MiniMax團隊透露,該模型在強化學習階段的算力成本僅為50多萬美元,這無疑是一個以小博大的成功案例。

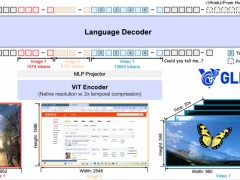

深入了解MiniMax-M1后,我們發現了其背后的兩大亮點。首先,該模型采用了一種名為“閃電注意力”的機制,這是一種對傳統注意力機制的優化,通過減少模型在處理數據時的讀寫次數,從而大幅提升了效率。

其次,MiniMax-M1在RL訓練框架上也進行了創新。針對推理模型中常見的“嗯”、“等等”、“啊哈”等語氣詞,MiniMax提出了一種名為CISPO的新算法。該算法通過略微調低這些詞的影響力,既能讓AI學到關鍵的推理思路,又不會因這些語氣詞而干擾整個訓練過程。

在實際體驗中,MiniMax-M1的表現同樣令人印象深刻。在上下文長度的測試中,該模型展現出了強大的能力。以一本約20萬個單詞的電子書《白鯨記》為例,我們在其中偷偷加入了一句話:“某人吃了生蠔后掉進了泥里”。當詢問MiniMax-M1時,它迅速且準確地給出了回答,而DeepSeek則因無法處理如此長的上下文而敗下陣來。

在科研文獻的翻譯上,MiniMax-M1也展現出了其獨特的優勢。它能夠保持原文的格式,準確翻譯內容,并將公式和圖片完美嵌入到翻譯結果中,為科研人員提供了極大的便利。

然而,在編程能力的測試中,MiniMax-M1的表現則稍顯不足。盡管它能夠完成一些基本的編程任務,但在處理復雜邏輯和動畫效果時,仍存在一定的提升空間。

盡管如此,MiniMax-M1的發布仍然為AI大模型領域帶來了新的活力和期待。同時,MiniMax還宣布了為期五天的連更計劃,每晚都將推出一款新模型,這無疑將進一步激發行業的關注和討論。讓我們共同期待MiniMax后續的表現吧!