蘋果公司近期在Hugging Face平臺上推出了一項引人注目的技術進展——FastVLM視覺語言模型的瀏覽器體驗版。這一創新舉措讓用戶無需復雜設置,即可通過網頁直接探索FastVLM的強大功能。

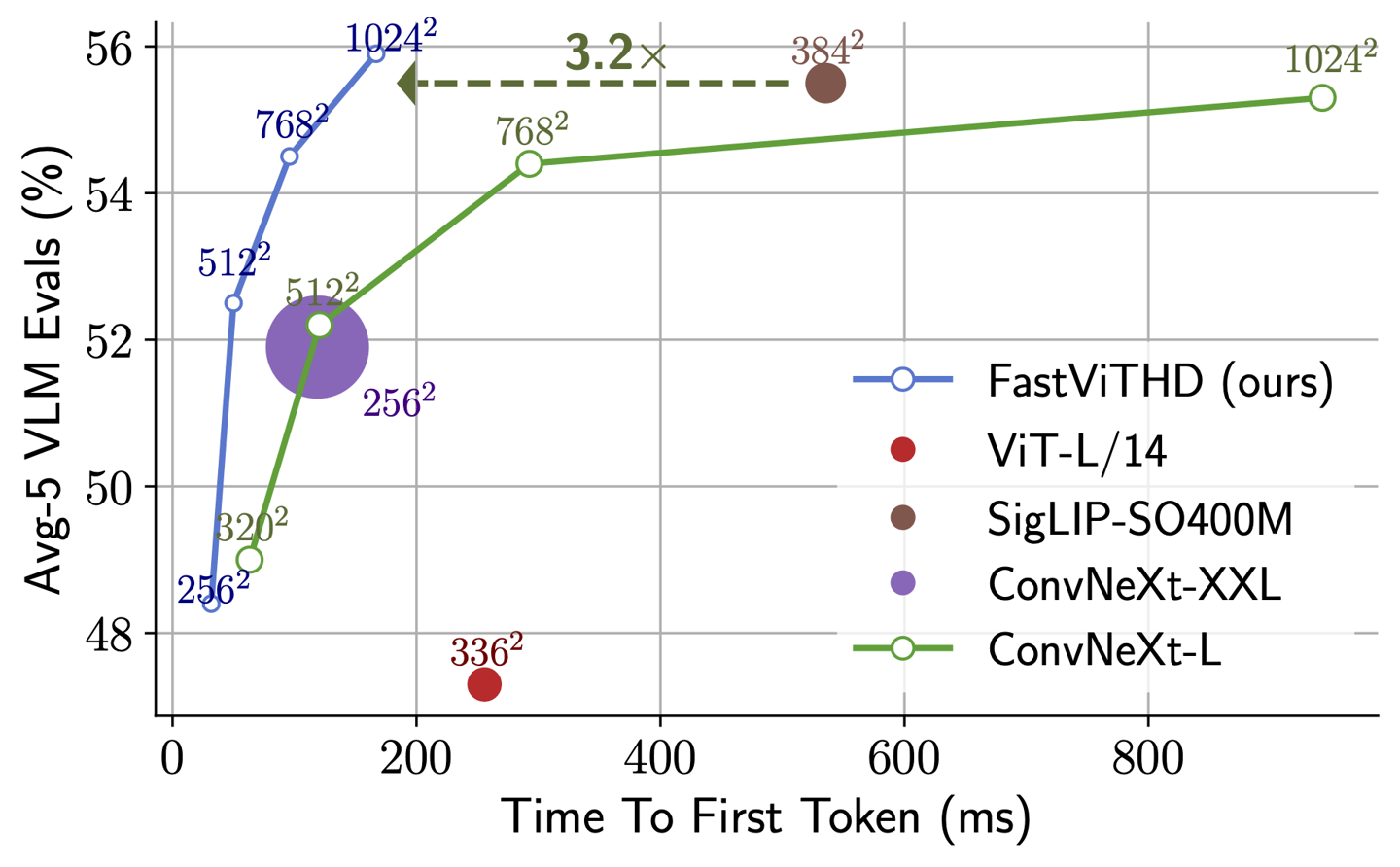

FastVLM尤其以其卓越的視頻字幕生成能力贏得了廣泛關注。在Apple Silicon芯片的Mac設備上,該模型展現出流暢的運行表現和顯著的實用性。據悉,FastVLM基于蘋果自研的開源機器學習框架MLX進行了深度優化,特別針對Apple Silicon芯片進行了適配。相較于其他同類模型,FastVLM的體積大幅縮減至原來的三分之一,同時處理速度卻提升了驚人的85倍,這一性能提升尤為亮眼。

此次推出的FastVLM-0.5B輕量級版本,用戶只需在瀏覽器中即可輕松加載運行。在測試中,一款配備16GB內存的M2 Pro版MacBook Pro首次加載該模型雖需數分鐘,但一旦啟動成功,模型便能迅速準確地識別視頻畫面中的人物、環境、表情及多種物體,展現了其高效能。

尤為FastVLM支持在本地設備上運行,這意味著所有數據處理均在用戶設備上完成,無需上傳至云端服務器,從而為用戶隱私提供了有力保障。這一特性在當前注重數據安全的時代背景下,顯得尤為重要。

FastVLM的低延遲特性和本地運行能力,為其在可穿戴設備及輔助技術領域的應用開辟了廣闊前景。例如,在虛擬攝像頭應用中,該模型能夠實時提供豐富細致的場景描述,為用戶帶來前所未有的交互體驗。未來,隨著技術的不斷成熟,FastVLM有望成為智能穿戴設備的重要技術支撐,推動人機交互向更加智能化、便捷化的方向發展。